加大投入、大幅降价,阿里云发起进攻。

文丨贺乾明

中国互联网行业从强调降本增效到转回扩张,只需要看到一次技术突破。

4 月 11 日,阿里巴巴董事局主席兼 CEO 张勇接手阿里云 103 天后首次公开亮相,带队公布阿里的类 GPT 大模型 “通义千问” 及相应的应用规划。

相比同行们把重心放在大模型和问答产品上,阿里强调云计算和大模型能力的结合。“所有行业、应用、软件、服务,都值得基于大模型的能力重做一遍。” 张勇在今早的演讲中说。

基于这一新思路,张勇展示了一个从阿里云开始,用大模型改造整个阿里集团的规划。

划归阿里云集团的钉钉、天猫精灵等业务已经在测试用大模型提高办公效率和使用体验。之后,大模型能力还会被推广至淘宝、天猫、高德、夸克、优酷等业务,提高用户购物、搜索、使用导航等场景的体验。

与此同时,阿里云也将大模型看作新的增长动力,希望以此增加老客户黏性,也吸引更多新客户。

配合新的规划,阿里云宣布新促销措施以吸引客户,比如推出最多降价 70% 的新存储服务,不要钱让开发者试用的云服务增加到 50 多项,免费试用时长从 1 个月增加到 3 个月,覆盖服务器、数据库、机器学习平台等训练人工智能模型的全环节。张勇还承诺,未来会将算力成本降低到现在的十分之一甚至百分之一。

就在几个月前,尚未从阿里巴巴集团体系分拆的阿里云仍在强调 “高质量增长” 和盈利。两周前的重大组织变革后,阿里集团将主要业务拆为 “1+6+N”,云成为更独立的公司,更需要现金流和利润,不过在巨大的机会面前,它更倾向于超前投入。

人工智能大模型改变了云计算在中国的前景

今年 2 月的财报会上,张勇多次用 “激动人心” 形容大模型驱动的生成式人工智能带来的变化。

这之前,中美云计算公司面临不一样的市场环境。亚马逊旗下的云服务 AWS 的客户遍布各行各业,从美国证券交易所、大型石油公司、银行业到 Netflix 等互联网公司,都愿意将数据放到 AWS 上,拥抱云计算服务的速度和灵活性。去年 AWS 经营利润超过 230 亿美元。而中国云计算市场有自己的特殊性。中国一些大客户建 IT 设施,“习惯于自己掌控”,经常需要云服务商从采购服务器建机房开始做起,最后才是软件解决方案,且不同客户之间的技术复用程度很低,难以降低边际成本。过去几年,在线教育行业客户减少和网络游戏行业增量变少,也影响了中国云计算公司的生意。

IDC 在 2022 年底的预估中,把中国云计算行业未来五年的平均增速下调到 20%,比半年前少了 10 个百分点。IDC 强调,考虑到宏观经济状况,这个增长率已相当可观。

但 ChatGPT 的出现,很有可能改写中国云计算市场的增长态势,压在阿里云头上不远处的天花板正被抬升。

需求量在变大。大模型的惊人能力让原本收紧支出的客户又愿意投入了。一个例子是,微软的云服务 Azure 在中国云计算市场本没有太强的存在感,更多是接入跨国公司的中国业务,但现在客户多到排队。因为它是 OpenAI 商业化的唯一云代理商,中国企业如果要在境内稳定使用 ChatGPT 背后的大模型,就只能找微软。

在融合更强的人工智能能力前,许多公司口中的 “智能云” 其实并不足以智能到让客户持续买单。

云计算以往更多卖的是计算能力、存储、带宽资源等。即使是更依赖软件能力的一些功能,也不是那么不可替代。如潮牌电商得物曾使用字节火山引擎的推荐算法服务,但后来换成了自研团队,他们认为 “效果差不多”。

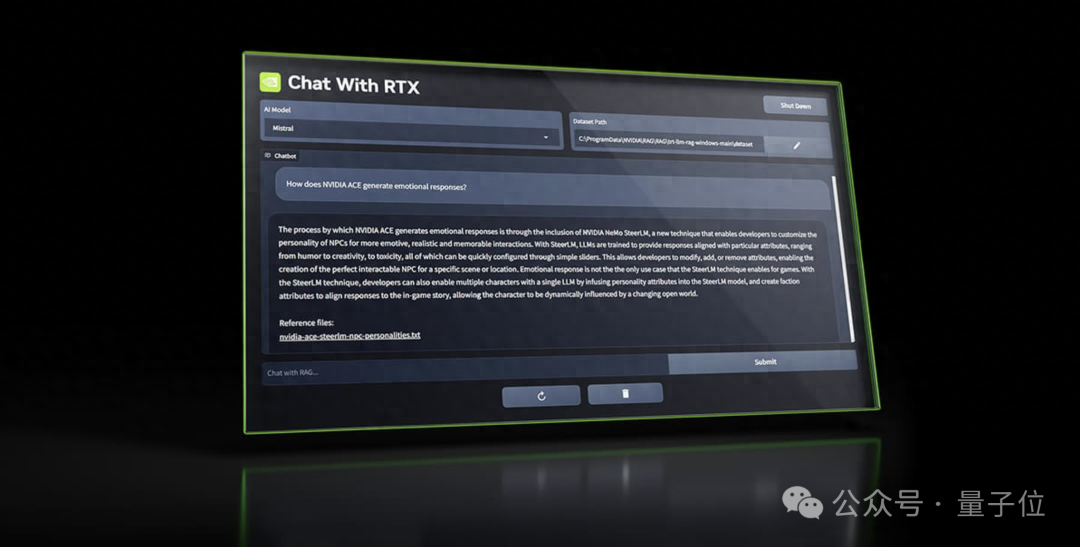

而一家公司要开发类似 ChatGPT 的应用,从训练大模型到调整模型至可用状态,再到实际应用,每个步骤都需要大量云计算资源、AI 能力和配套工具——如数据处理工具、开发模型的框架、自动根据负载配置算力的系统等。

拥有资源优势的运营商在开发复杂软件设施时,效率往往不如大型云计算公司。有一定软件能力的公司,大部分又不愿意花上百万甚至千万美元从头训练一个类似 GPT-3 的大模型。一位中型互联网公司负责人近期告诉我们,“现在大模型开发背景的人都很难招到”。他们更倾向于调用大公司训练的大模型,针对特定场景做优化,对外提供服务。

基于大模型开发人工智能能力,还可以减少云计算厂商服务客户时的定制化投入。阿里云 CTO 周靖人今天接受访谈时称,以前帮一个客户开发人工智能应用,要从头开始拿数据、做标注、做训练;而有了预训练大模型后,模型的构建、训练和使用都发生了 “范式变化”:“现在不需要标注,也不需要从头开始训练了。” 在预训练基础上做微调的方式也有多种选择,客户可以自己微调(fine-tune),也可以做有监督的微调(SFT)训练,还可以直接在提示、指令层(prompt)上做调整。这有助于帮云计算公司摆脱做 “集成方案” 的处境。

阿里云还希望借大模型扩展公有云市场,让一些原本只愿意把软件和数据放在自己服务器上的公司,也能接受公有云。周靖人称相比私有云,公有云服务更标准化,更能发挥超大规模计算集群的弹性计算能力,训练大模型的效率也更高,这对商用部署尤其重要。公有云是阿里相比运营商和华为的优势所在。

硅谷风投机构 a16z 与数十位相关创业者交流后发现,大型云计算等基础设施供应商,可能是迄今为止新一轮人工智能浪潮中的最大赢家,它们长期投入建设的数据中心和计算能力形成了竞争优势。a16z 估算,云计算公司会获得生成式人工智能产品收入的 10%-20%。

a16z 认为,想从头训练大模型的创业公司得把自己融资的 80%-90% 交给云服务商。OpenAI 2019 年找微软拿的 10 亿美元投资,基本上都还给了微软的云计算部门。

从产品、生态到业务,阿里云全线布局

在主旨演讲中,张勇说移动互联网和各行各业数字化推动了阿里云过去的增长,大模型将会给阿里云带来更多可能。在云峰会上,阿里云集中展示了它准备怎样抓住大模型带来的增长。

云计算峰会前几天,阿里云开放 “通义千问” 测试,强调它能较好地写电影剧本、短文、邮件等,有较强中文语言处理能力,同时具备写代码的能力。

为吸引更多开发者尽快了解阿里大模型能力,阿里这次给出了降价和更多免费试用的优惠,可免费试用的产品从过去的几个增加至 50 多个,最长试用时间也增加至 3 个月。

在大模型基础上,阿里云开发了一系列工具降低客户使用大模型的门槛,贯穿数据收集、模型预训练、微调和使用整个流程。

周靖人说,阿里云会给客户提供一个专用数据空间,供客户上传模型所需的数据。这些数据不需要做清理和标注,PPT、Word、PDF、宣传册和各种图片或视频都可以,接着,阿里的通用大模型将学会这些数据中的行业知识,再根据客户要求,微调出客户想要的专属大模型。阿里云称,OPPO 安第斯智能云是其企业专属大模型的首批客户之一,双方将联合打造 OPPO 大模型基础设施。同时,中兴通讯、吉利汽车、智己汽车、奇瑞新能源、毫末智行、太古可口可乐、波司登、掌阅科技等也将与阿里云展开合作探索。

同时,阿里云还分别发布了优化大模型训练和部署过程的产品,单集群最大能够调用 10 万个 GPU,降低训练和部署的成本与时间。

阿里云从 2019 年开始训练大模型,曾陆续发布语言大模型 Plug(后来的 AliceMind)、10 万亿参数的多模态大模型 M6,这些成果在去年整合为 “通义” 大模型。周靖人说,这是阿里能快速推出 “通义千问” 并提供相应服务的基础。目前阿里云直接开发大模型的研发人员约有数百人,仅达摩院语言实验室就有 100 多人。

为推广基于模型开发人工智能的新开发方式,即阿里去年提出的 MaaS(Model as a Service,模型即服务),阿里云去年 11 月上线了 “魔搭”(ModelScope)社区,聚集了多个机构开发的人工智能大小模型,开放给更多人使用。周靖人说社区发展超出预期,短短几个月,已经有上百万人下载了 1600 万次各类模型,模型数量从最初的 300 多个扩展到 800 多个,其中十亿参数以上的大模型有 30 多个,超百亿参数的大模型有 10 个。

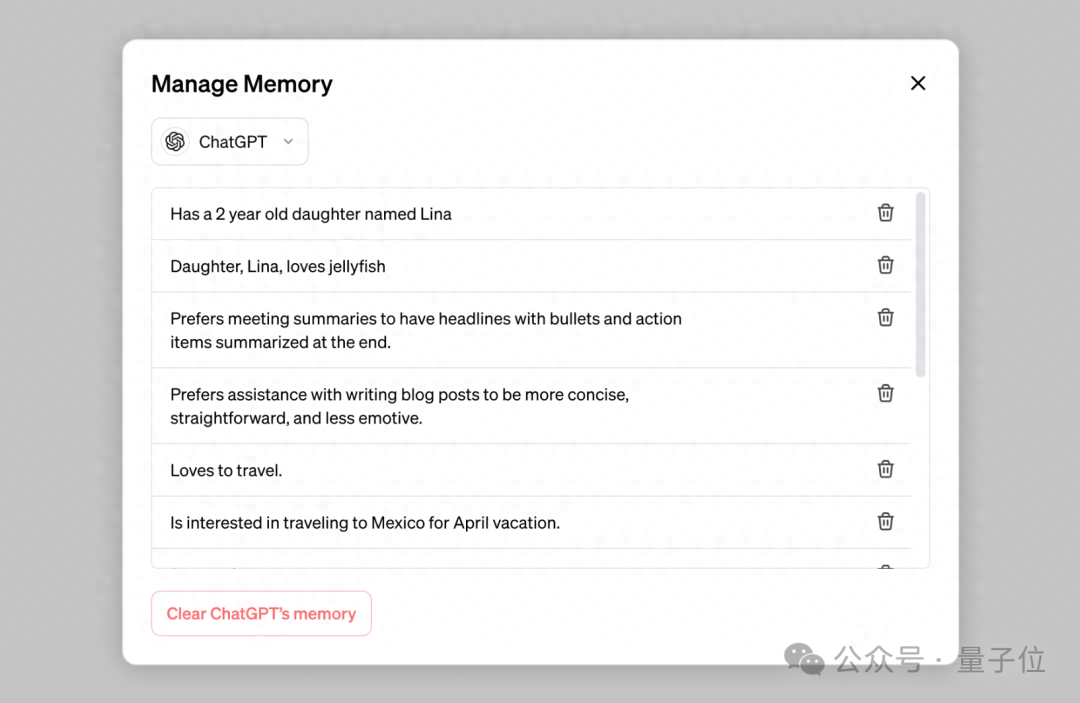

阿里云还在用大模型改造钉钉、天猫精灵等产品。根据阿里云的宣传视频,在钉钉中,它是一个个人助理,用户能用通义千问生成营销策划方案、自动总结会议纪要或未读群聊信息中的要点,甚至还能像 GPT-4 那样,上传一张功能草图,不写一行代码,就生成订餐小程序。在天猫精灵中,大模型则是一个更复杂的生成式对话系统,需先进行语音指令的识别,并克服延时问题,它能根据用户一两句话的需求,自动生成一个故事、歌单或食谱。目前这些功能还在测试阶段,并未发布。

在更长远的规划中,阿里还描绘了怎样用大模型改变你的电商购物体验:你在淘宝或天猫的搜索框里输入问题,它会为你生成一个购物方案,并给出相应的购物列表。

张勇认为,阿里集团体系内不同性质的业务,都面临着同样的历史机遇,接入大模型后有可能做到 “以前不敢想,也没想到的事情”。

新的机会、新的对手

去年 11 月底,ChatGPT 靠强大的能力迅速传遍世界,许多公司关注怎样做出一个类似的产品。但大多数公司,包括大多数科技巨头都不需要从头做一个大模型。

在每一次软件技术迭代中,当一家公司凭借重要新技术遥遥领先时,距离不远的追赶者们往往会推出开源产品,引入其他参与者与其分庭抗礼,比如智能手机操作系统 iOS 与 Android,以及去年的人工智能作图应用:OpenAI 去年 4 月发布了领先的模型 DALL·E 2,大半年后,开源的 Stable Diffusion 借助开发者的力量,成为了人工智能作图应用领域使用最广泛的模型。

GPT-3 推出一年多,拿到亚马逊投资的人工智能社区 Hugging Face 就推出了自己的开源大模型 BLOOM。ChatGPT 上线几个月,Meta 的 LLaMA 开源大模型就已经出现。

这些开源产品极大降低了公司使用新技术的成本。现在许多大公司或创业公司都开发出了自己的 ChatGPT 应用。在阿里云召开云峰会前一天,中国有两家公司发布大模型,还有大模型创业者宣布启动公司。

Google 的 CEO 桑达尔·皮查伊(Sundar Pichai)最近被问到没有抢在 ChatGPT 前发布 Bard 错过什么时,他说 Google 在很多领域都不是第一个推出产品的,Google 没开发第一个搜索引擎,第一个浏览器等,“有时候成为第一很重要,但有时候无关紧要。” 他认为,更重要的是不断改进产品,做出更好的模型,实现更好的功能。

现在,用开源模型做一个可用的大模型应用并不难,难的是怎样在长期的竞争中占据优势。从微软与 OpenAI 过去几个月的经历看,关键的竞争因素有三:

-

计算基础设施。OpenAI 近期暂停付费用户引起了算力紧缺的讨论,它或许把微软 Azure 能给它的资源都用完了。作为世界第二大云计算平台,微软 Azure 都难以支撑 OpenAI 的扩张。对于其他想抓住这个机会的云计算公司来说,提供类似的服务,得有可观的 GPU 计算资源。

-

专有数据。市场上多数预训练大模型都是用一样的架构、公开数据集和类似的方法训练的。大模型拥有不同能力的关键在于用什么样的数据去微调它。这些数据的多少、质量的差别,将会直接决定一个大模型的能力。OpenAI 的 GPT-4 变得更强,其中一部分原因就是加入了合作伙伴提供的独占数据。

-

商业应用。基于大模型做应用不难,但想要基于百亿甚至千亿参数的模型做应用,需要大量 GPU 做推理计算,成本很高。这意味着必须找到商业价值足够大的场景,才能让大模型应用变得划算。而且在更庞大的应用场景中,大模型供应商也能得到更多用户的反馈,不断改进模型。

上述每个方面都更偏向有大量数据、计算资源和有业务场景的大型云计算公司。在中国市场,公有云份额最大、投入时间最长的阿里云,可能是最有机会的那家。

准备大力投入大模型的不止阿里云一家,其他有一定竞争力也有意愿的公司还有百度、字节等。《晚点 LatePost》此前提到,字节跳动正在张一鸣的密切关注中,投入三个团队做大模型。火山引擎团队同样把大模型视为关键的发展机会。

大模型在云计算领域引发的竞争或许只是暂时的,长期它可能会在更大范围带来改变。微信等有限的应用外,今天中国所有用户上亿的应用都依赖推荐算法让用户多用几分钟,增加广告收入。而在十多年前,推荐算法还只是少数应用中的新尝试。

大模型同样有可能改变我们使用的每一个应用。在主旨演讲中提到 “通义千问” 时,张勇并没有谈论模型不完美的地方,而是强调未来才刚刚开始:“不管谁做了怎样的大模型或者专属大模型,十到二十年后回头看,会发现这段时间所有的企业都在一个起跑线上。”

· FIN ·

发评论,每天都得现金奖励!超多礼品等你来拿

登录 后,在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则