光线角度都能适应

克雷西 发自 凹非寺

量子位 | 公众号 QbitAI

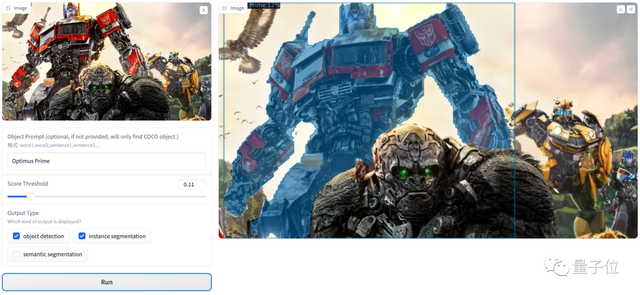

点两下鼠标,就能把物体无缝「传送」到照片场景中,光线角度和透视也能自动适应。

阿里和港大的这个AI版「任意门」,实现了零样本的图像嵌入。

有了它,网购衣服也可以直接看上身效果了。

因为功能和任意门十分相似,所以研发团队给它起的名字就叫AnyDoor。

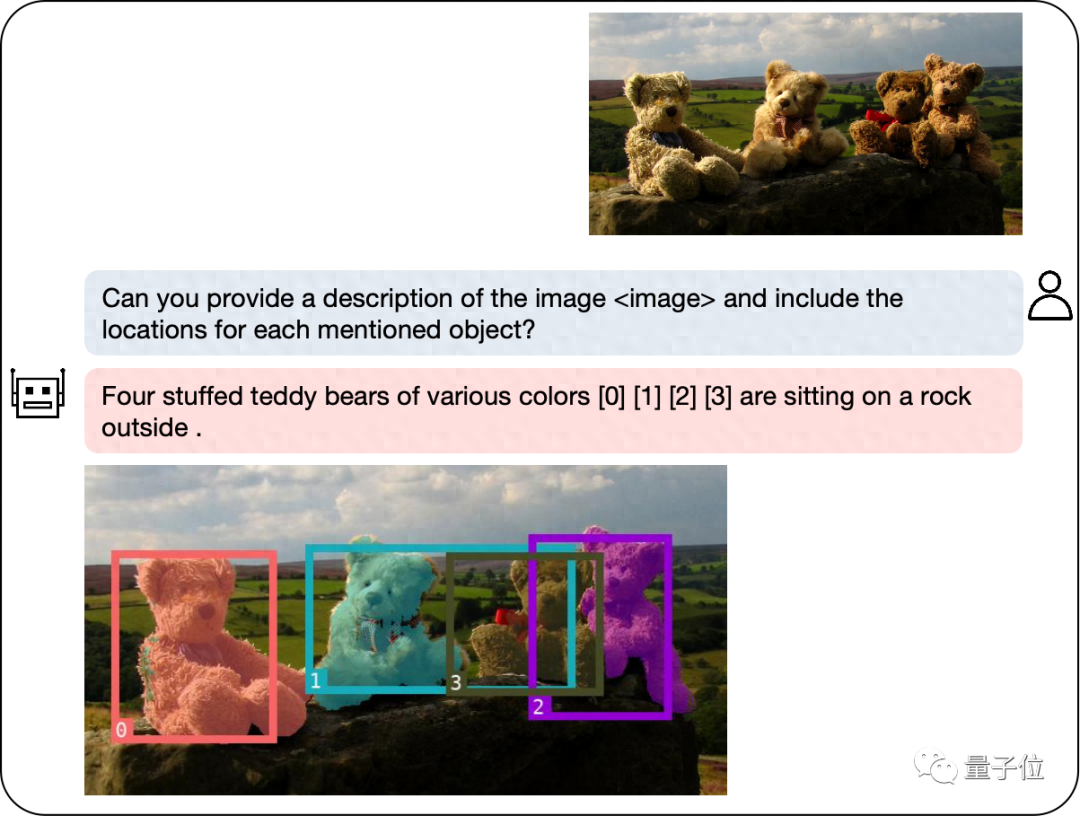

AnyDoor一次能够传送多个物体。

不仅如此,它还能移动图像里的已有物品。

有网友看了之后赞叹到,或许接下来就会进化到(把物体传入到)视频了。

零样本生成逼真效果

相对于已有的类似模型,AnyDoor具有零样本操作能力,无需针对具体物品调整模型。

除了这些需要进行参数调节的模型之外,AnyDoor相对于其他Reference类模型也更为准确。

实际上,其他的Reference类模型只能做到保持语义一致性。

通俗地说,如果要传送的物体是一只猫,其他模型只能保证结果中也有一只猫,但相似度无法保证。

我们不妨把AnyDoor的效果放大看看,是不是看不出什么破绽?

用户评价的结果也证实,AnyDoor在质量和准确度方面表现均优于现有模型(满分4分)。

而对于已有图像中物体的移动、换位,甚至改变姿态,AnyDoor也能出色完成。

那么,AnyDoor是如何实现这些功能的呢?

工作原理

要想实现物体的传送,首先就要对其进行提取。

不过在将包含目标物体的图像送入提取器之前,AnyDoor首先会对其进行背景消除。

然后,AnyDoor会进行自监督式的物体提取并转换成token。

这一步使用的编码器是以目前最好的自监督模型DINO-V2为基础设计的。

为了适应角度和光线的变化,除了提取物品的整体特征,还需要额外提取细节信息。

这一步中,为了避免过度约束,团队设计了一种用高频图表示特征信息的方式。

将目标图像与Sobel算子等高通滤波器进行卷积,可以得到含高频详情的图像。

同时,AnyDoor利用Hadamard对图像中的RGB色彩信息进行提取。

结合这些信息和过滤边缘信息的遮罩,得到了只含高频细节的HF-Map。

最后一步就是将这些信息进行注入。

利用获取到的token,AnyDoor通过文生图模型对图像进行合成。

具体来说,AnyDoor使用的是带有ControlNet的Stable Diffusion。

AnyDoor的工作流程大致就是这样。而在训练方面,也有一些特殊的策略。

△AnyDoor使用的训练数据集

尽管AnyDoor针对的是静态图像,但有一部分用于训练的数据是从视频当中提取出来的。

对于同一物体,视频当中可以提取出包含不同背景的图像。

将物体与背景分离后标注配对,就形成了AnyDoor的训练数据。

不过虽然视频数据有利于学习,但还存在质量问题需要解决。

于是团队设计了自适应时间步采样策略,在不同时刻分别采集变化和细节信息。

通过消融实验结果可以看出,随着这些策略的加入,CLIP和DINO评分均逐渐升高。

团队简介

论文的第一作者是香港大学博士生陈汐(Xi Chen),他曾经是阿里巴巴集团算法工程师。

陈汐的导师Hengshuang Zhao是本文的通讯作者,研究领域包括机器视觉、机器学习等。

此外,阿里方面还有来自达摩院、菜鸟集团的研究人员也参与了这一项目。

论文地址:

https://arxiv.org/abs/2307.09481

发评论,每天都得现金奖励!超多礼品等你来拿

登录 后,在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则