现如今,AI(人工智能)已经成为了一个逃不掉的话题..

不管是横扫围棋界各大高手的阿尔法狗….

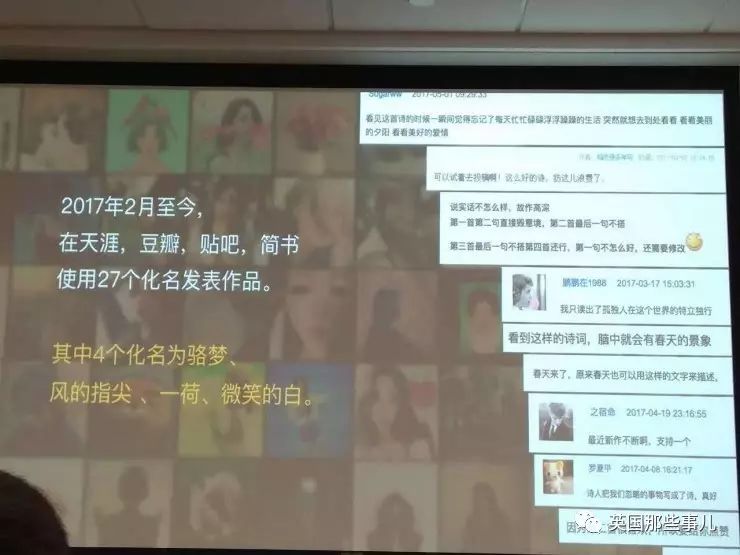

还是用不同化名在网上发表诗歌,都没有被人察觉的微软小冰…

最复杂的游戏,最微妙的情感,

AI似乎够能和人一样做出来,甚至,比人做得更好…..

但它们不止于此,更是早已来到了司法界。

最近美国有一起充满争议的案子,

一个因为偷窃罪被判刑的男人把威斯康星法院告了,

因为…

他被判整整8年有期徒刑,不是因为他的罪行,也不是因为法官的判断,

而是因为,一个AI认为,他对社会具有‘高危险性’!

事情要从2013年说起…

那年的2月11日,威斯康星州的拉克罗斯市出现了枪击案。

有目击者们看到一辆车行驶过Kane大街2200号房子的时候,车里的人突然掏出枪向屋子开了两枪。

目击者马上报警,并且告诉警察关于车子的信息。

之后,警方在别的地方找到这辆车,马上展开激烈追捕,最后好不容易把车子逼停了,看到了31岁的Eric Loomis和他的小伙伴….

警方在车子里发现一些枪支,

本以为是人赃俱获,但仔细彻查后发现…..

这两人,根本不是枪击案的罪犯,而是在错误的时间错误的地点出现的窃车的小偷。

警方调查发现,枪击案罪犯弃车逃跑后,这个小偷顺手把这辆车给偷了…..

案情确凿,于是法院判两人有盗窃罪和拒捕罪。

原本,这案子并不算大,但是在Eric Loomis接受了一个叫做COMPAS的软件系统的提问后,法官宣布,判处Eric Loomis长达8年6个月的有期徒刑。

这么长的刑期,Eric Loomis简直懵逼了…..

法官Scott Horene给出的理由是这样的:

‘根据COMPAS的测试,被告被认定为对社会具有高危险性的人。’(“identified, through the COMPAS assessment, as an individual who is at high risk to the community.”)

COMPAS……

这到底是个啥??

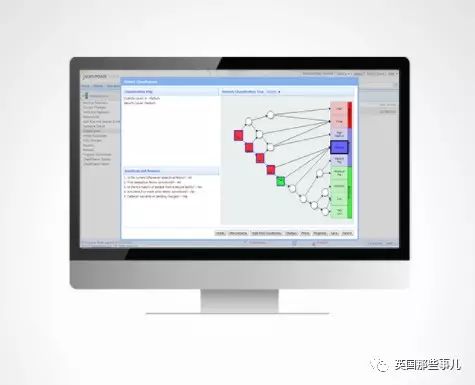

COMPAS是一个由私营企业编写出的、能够帮助司法人员做出判断的智能AI。

它通过向被告询问137个问题(比如‘你在学校多久打一次架’;‘你有多少朋友非法使用药物’;‘你受过的最高教育是什么’),还有搜索他曾经的犯罪记录,得到一堆数字,

然后经过公司设定的复杂算法,最终得出一长串数据。

里面包括他的孤僻程度、犯罪型人格的得分、性格稳定度….以及最重要的,他的‘危险指数’,也就是‘未来再次犯罪的可能性’。

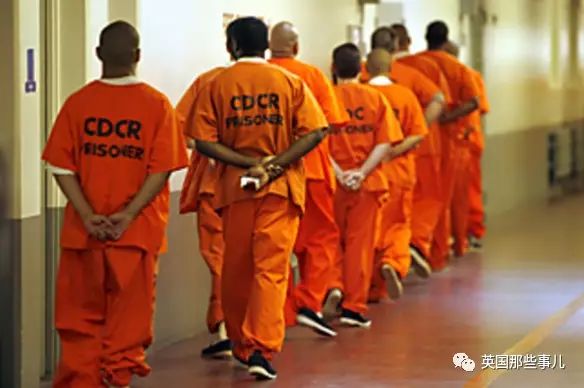

COMPAS在美国很多个州中都被使用,其中使用最广泛的是威斯康星州。

从2012年起,威斯康星州就鼓励在全州所有法庭上都用COMPAS,在监狱系统中的每一部分也使用它,给犯人做出评估,协助司法人员进行判刑到假释的判断….

因为….COMPAS实在太好用了,

它告诉人们的答案太清晰了!

这个AI能清楚地说出每个被告的‘危险指数’是多少,从1到10,10为最危险,说明被告再次犯罪的可能性极高。

根据这个数据,能够帮助法官判断,

是判他早早出狱,还是在监狱里多待两年,免得出去祸害社会…..

除此外,COMPAS还能告诉司法人员,

最适合被告的监禁类型是什么,

被告什么时候才能被假释,

监狱里这么多人,谁最适合提前释放,

保释金需要多少钱,

……

只要有人问,

COMPAS几乎能回答关于罪犯和监禁的所有问题!

威斯康星州惩教部的部长Jared Hoy曾经说,这个AI简直太好用。

它给人的惊喜不断,建议每个工作人员做决定的时候都可以用一用。

对工作人员可能是好事….

但对被告来说,这简直就是莫名其妙….

Eric Loomis听到结果后,马上表示不服,

‘为什么我会被评为是对社会有高危险度?理由呢?

而且还是用一个软件来评判我,这不合理!’

按照美国第六修正案,被告有权知道被控告的理由,

那么他被控‘有高危险度’的理由是什么呢?

COMPAS:抱歉,我不能说。

是的,因为COMPAS是一个商业产品,有知识产权,所有除了公司的核心成员,它的具体算法不能被外界知道,

就算是用它用了很多年的法院,他们也不知道算法长什么样,只能看到结果….

所以,COMPAS就像是一个黑匣子。

Eric Loomis被判为‘高危险’,也许是由于他在‘受教育程度’那里分数很低,也许是由于在‘是否住在危险街区’中回答了‘是’,也许是COMPAS认为他在回答中撒谎…..

总之,没人知道。

于是,不满的Eric Loomis决定上诉,一路闹到威斯康星州最高法院,

但最终,法院仍然认为COMPAS的判断没有问题,它‘科学又有效’。

在扯了几年的皮后,Eric Loomis的刑罚最后被降到6年,但他觉得还是很长…..

为什么威斯康辛星就是对COMPAS如此痴迷呢?

法院方面表示,因为COMPAS的优点很大啊!

它就是一堆冷冰冰的算法,很客观,完全不受个人情感因素的影响。

使用COMPAS,法官能够更公正无私地看待案子,最大化地消除偏见。

这就是法院大力使用的原因…..

但根据非盈利新闻社ProPublica的研究,

COMPAS似乎并没有那么完美…..

在COMPAS的137个问题中,没有询问被告关于‘种族’的问题,这也是人们说它客观的原因。

但在2016年,ProPublica却发现了很多‘AI种族歧视’的情况。

比如,

黑人女孩Brisha Borden和白人大叔Vernon Parter因为盗窃罪被捕,两人都被控窃取价值80美元的东西。

女孩之前有过4次行为不当,没有入狱经历;而大叔有过两次持枪抢劫,还曾经坐过5年牢。

结果女孩被COMPAS判断的危险指数是8,属于‘高危’,而大叔的指数却是3,属于‘一般危险’…..

再比如,下面两小哥都因为携带毒品被捕,

左边的白人Fugett曾经因为持有可卡因和大麻,被警方抓捕过三次,还犯过一次抢劫案,COMPAS认为他的危险指数是3分;

而右边的Parker,只有过一次拘捕,只是逃跑,没有袭警,却被COMPAS认为危险程度极高,有10分。

明明是个死物的COMPAS,

为什么会像种族歧视者呢?

人们不知道,但考虑到COMPAS在问题中问的各种因素,

比如家庭、街区、是否有工作、最高学历、父母是否吸毒等等,看上去和个人有关,但实际上是受社会大环境影响,黑人处于的弱势环境,让他们在AI的评测中更加吃亏….

因为算法本身不客观,

那么COMPAS的正确率也不会有多高….

在2016年,ProPublica通过COMPAS计算了7000多名罪犯在刑满后再次犯罪的可能性。

这些罪犯来自加利福尼亚州的Broward市,被COMPAS测评‘危险指数’的时间是2013年到2014年。

结果…只有20%的人会按照COMPAS预测的那样再次犯罪,

如果把所有的犯罪类型都算上,比如用一个过期的驾照开车这种小罪,那么COMPAS的正确率为61%。

而Eric Loomis的这个案例….

因为所谓的‘危险指数’偏高,而不得不被听信AI的法官判更长时间的牢。 他自己觉得,确实感觉挺冤…

现在,犹他州、弗吉尼亚州,很多地方都在使用类似的AI来帮助审判,预测犯罪,

这是美国司法界的趋势,

也许,这也将是是全球的趋势….

但犯罪是一个极其复杂的社会问题,

AI能干得好吗,它真的能像公正无私的审判者一样,做出完美的判决吗?

法官判案,有人说法官受人性影响,会有偏差…

让AI来评估,实际证明也不完美….

那,什么又才是正确的路呢?

ref:

https://www.propublica.org/article/machine-bias-risk-assessments-in-criminal-sentencing

http://bigthink.com/robby-berman/a-judge-lets-an-app-help-him-decide-a-wisconsin-mans-6-year-sentence

http://www.northpointeinc.com/files/downloads/DataSheet_Classification.pdf

http://www.equivant.com/solutions/inmate-classification

https://www.theatlantic.com/technology/archive/2016/06/when-algorithms-take-the-stand/489566/

——————-

骨子–背不完局解生理生化不当人:PSYCHO PASS…………

王安石:人工智能真的好吗?别像电影里那样被我们制造的机器人给统治了

大鸣咚咚哩个呛:可以让法官自己测一测危险系数

Y菌_冬日饺子:《美国队长2》,洞察计划

孩子气的小小倩:我只能说,这个真的是有那么一点的荒谬了

熊阿冷:阿汤哥有一个电影叫少数派报告,讲的是人工智能可以预知犯罪然后司法机关就去在犯案前抓住,结果后面发生了一系列细思恐极的事…

Lucien陈:AI没偏见,但是编写AI程序的人有啊!最终不还是有个人感情因素在里面吗?

数据被删除:我只记得之前那位因为减刑出来后成为人弹的英国骚年

——————-

发评论,每天都得现金奖励!超多礼品等你来拿

登录 后,在评论区留言并审核通过后,即可获得现金奖励,奖励规则可见: 查看奖励规则